- 软件简介

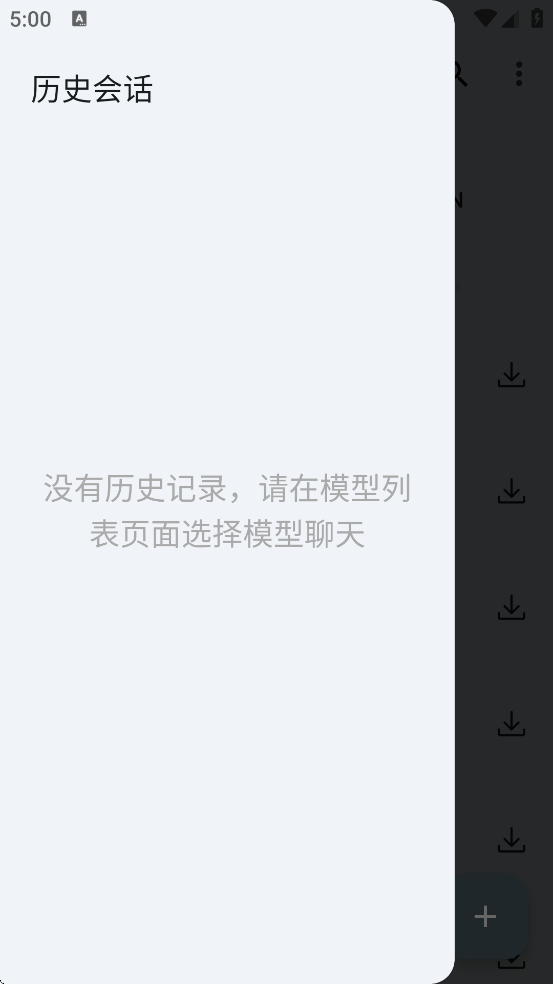

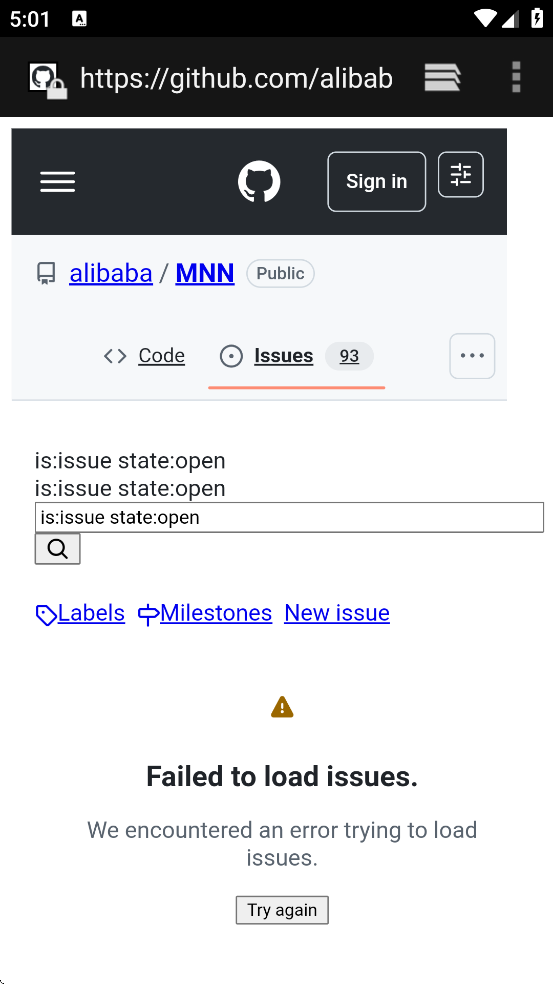

- 软件截图

- 下载地址

MNN Chat是一款由阿里巴巴开源的多模态大模型应用,只需要将软件下载到手机本地即可,你可以在里面使用市面上比较火热的智能对话AI大模型,软件的兼容性非常强大,可以在不同品牌不同操作系统的手机上面运行,流畅不卡顿而且引入的大模型的占存不大,软件会将其压缩量化。

软件特点

1、多模态支持:提供多种任务功能,包括文本生成文本、图像生成文本、音频转文本及文本生成图像(基于扩散模型)。

2、CPU推理优化:预填充速度相较于llama.cpp提高了8.6倍,相较于fastllm提升了20.5倍,解码速度分别快了2.3倍和8.9倍。

3、本地运行:完全在设备本地运行,确保数据隐私,无需将信息上传至外部服务器。

4、广泛的模型兼容性:支持多种领先的模型提供商,包括Qwen、Gemma、Llama(涵盖TinyLlama与MobileLLM)、Baichuan、Yi、deepseek、InternLM、Phi、ReaderLM和Smolm。

软件优势

1、主体功能(模型推理CPU+GPU)无任何依赖,代码精简,可以方便地部署到移动设备和各种嵌入式设备中。

2、iOS平台:功能全开的MNN静态库 armv7+arm64大小12MB左右,链接生成可执行文件增加大小2M左右。可裁剪主体功能后静态库大小6.1M ,链接生成可执行文件增加大小 600 KB。

3、Android平台:主体功能 armv7a - c++_shared动态库大小800KB左右。

4、支持采用 Mini编辑选项进一步降低包大小,大约能在上述库体积基础上进一步降低 25%左右。

5、支持模型FP16/Int8压缩与量化,可减少模型50% - 75%的体积。

软件亮点

1、无需网络连接:所有计算均在本地完成,节省流量消耗,同时保护用户隐私,避免潜在的网络攻击。

2、独立无依赖,代码结构精简:实现高度独立化,代码结构精简,适合部署至移动设备及嵌入式系统,提升部署效率和灵活性。

3、支持多种模型:提供多种大型模型选择,满足不同场景和需求,适合研究人员、开发者和普通用户。

4、高效资源利用:优化资源使用,确保设备性能得到充分释放,适合多设备用户同时运行多个模型。

5、适合多设备部署:支持不同机型选择不同模型,灵活适应各种设备需求,提升使用便利性。

6、易用性和扩展性:精简的代码结构和本地运行模式,确保软件使用简单,同时具备良好的扩展性,适合各类应用场景。

推荐理由

1、极速响应:消除了网络传输的延迟,用户可以获得更即时的AI响应。

2、数据隐私保护:用户的数据无需离开设备,大大降低了隐私泄露的风险。

3、节省流量:离线运行意味着无需消耗移动数据。

软件截图

下载地址

安卓下载立即下载